去年年底,ChatGPT横空出世,在全球科技浪潮中掀起了惊涛骇浪,随后,各个科技公司都开始着手打造自己的大模型,带来各行各业效率的革命和体验的升级。尽管大规模语言模型(LLMs,Large Language Models)可以进行复杂的语言生成和对话交流,但ChatGPT多模态感知、长期的运动规划和行为交互能力有限,还不是人类理想的智能体。“具身智能”+“机器人”有望成为AI的下一个潮水涌动的方向。

近年来,达闼在具身智能领域持续加大研发投入,上周发布了海睿AGI平台和机器人智能领域的多模态认知大模型——RobotGPT。达闼还与中山大学智能工程学院副教授、博士生导师梁小丹(国家万人青拔人才)展开紧密合作,共同探索具身智能前沿科技:为机器人开发非常真实的模拟环境,创建两个基准测试,助力机器人在自主推理和导航方面的研究更快地取得进展。

“具身智能”(Embodied Intelligence)意指有身体并支持物理交互的智能体,标杆产品是人形机器人。实现具身智能是指让机器能够像人一样拥有身体感知、交互和行动的能力,这种能力使机器能够更加自然地与物理世界进行交互。但是,实现具身智能面临着以下困难和挑战:

1 缺乏工业级真实感的机器人操作模拟器,缺少高质量具身智能训练所需的海量数据

通过与模拟环境进行交互生成大量丰富的多样的训练数据,并进行端到端强化学习和模型学习是具身智能训练的常用手段,当前业界的模拟器常常没有将智能机器人制造技术考虑在内,也没有足够的关注真实机器人应用的兼容性。这导致研究者在这种环境中开发的控制技术常常难以在真实场景中得到应用。此外复杂多变的现实环境也给具身智能有效地理解和解析环境信息带来了巨大的挑战。

2 机器人(智能体)难以理解和执行复杂且不明确的人类自然语言指令,同时缺乏机器人操作相关的渐进式推理任务基准测试

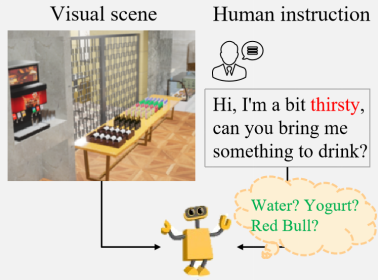

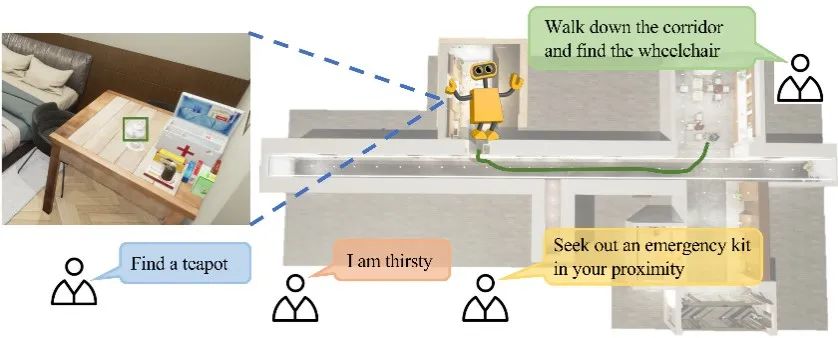

在具身智能研究中,人类的语言指令往往复杂多样、模棱两可、随意性强,机器难以猜测和推理人类的真实意图。比如我们对机器人说:“我有点渴,请给我拿点喝的”,如下图所示,机器人需要充分理解人的意图和场景中每个对象概念所隐含的功能,才能做出准确的判断。因此,考虑如何让机器人理解和执行复杂和模糊的人类自然语言指令是体现具身智能研究的关键挑战之一。

3 缺乏面向开放域零样本视觉语言导航的多任务基准测试

在具身智能领域,面对开放域零样本视觉语言导航多任务基准测试的明显缺失,主要是因为:仿真真实性不足,真实的开放环境下因素变化多端,比如突然走过来的行人;零样本视觉语言导航模型需要处理其以前未曾遇到过的环境和任务,这要求基准测试的环境尽可能地接近现实;相较于封闭环境,开放环境中的元素更加复杂且不断变化,现有的自动标注方法往往无法应对。

为了有效应对上述挑战,我们需要追求更为真实的仿真环境,开发更为有效的数据收集和标注策略,制定更为全面的评估指标。因此,达闼积极与中山大学展开了深度合作,在以下三方面取得了阶段性成果:

研发并开放工业级真实感的机器人具身智能训练工具(HARIX RDK)

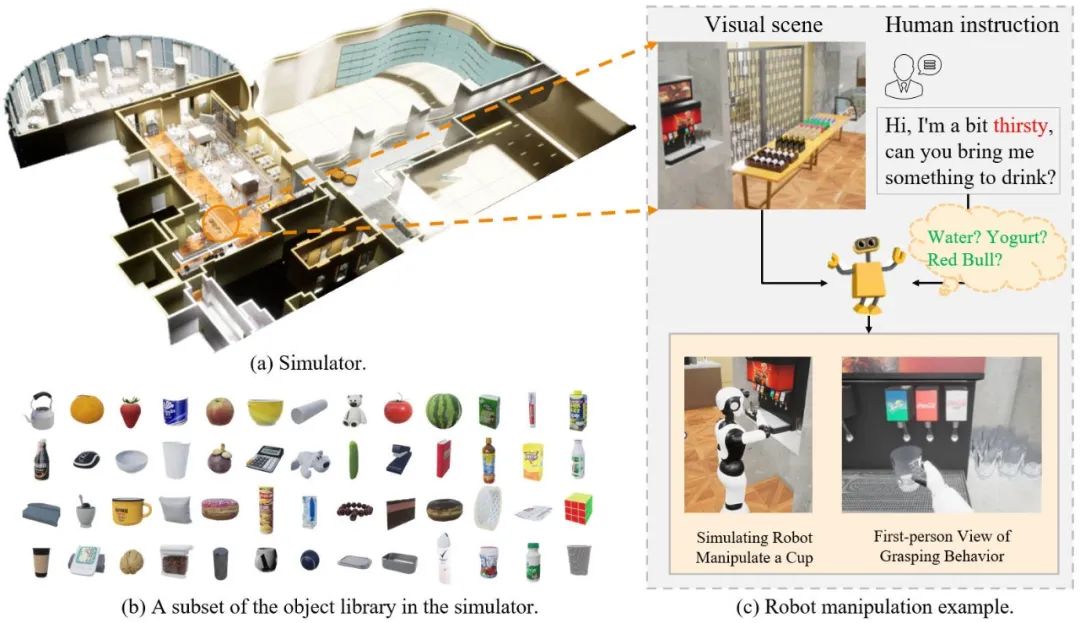

为了方便、公正地比较机器人在不同基线模型下理解和执行人类自然语言指令的成功率,我们构建了高度逼真的场景模拟与机器人具身智能训练工具(HARIX RDK),用于机器人具身智能的研究,特点有:①有真实光照,能够高拟真产生照明阴影、镜面反射、亮斑等。②仿真环境中加入了人类,这些人类或处于通道中阻挡路径或走入机器人行进路线。③环境可以通过读取底层数据实现对各类物体进行细致的语义分割标注,便于后续构建基准。④HARIX RDK可支持达闼公司研发的多种类型的机器人。

构建了机器人操作相关的渐进式推理任务基准测试,促进机器人渐进式推理研究的快速发展

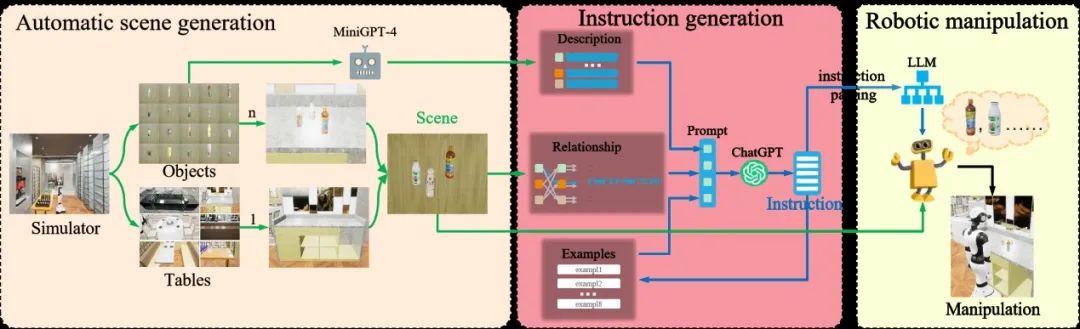

为方便分析和评估大语言模型在机器人操作中的应用,我们创建了一个通用的框架,如下图所示,主要由三部分组成:自动场景生成、指令生成和机器人操纵。自动场景生成负责生成丰富多样的场景供agent进行训练和测试。由于获取大规模复杂且高质量的人类自然语言指令既昂贵又困难,为此我们还设计了一个使用ChatGPT模拟人类自然语言指令生成的模块,为机器人操作提供自然语言指令。最后,通过向机器人输入生成的视觉场景和自然语言指令,控制机器人进行相应的操作。

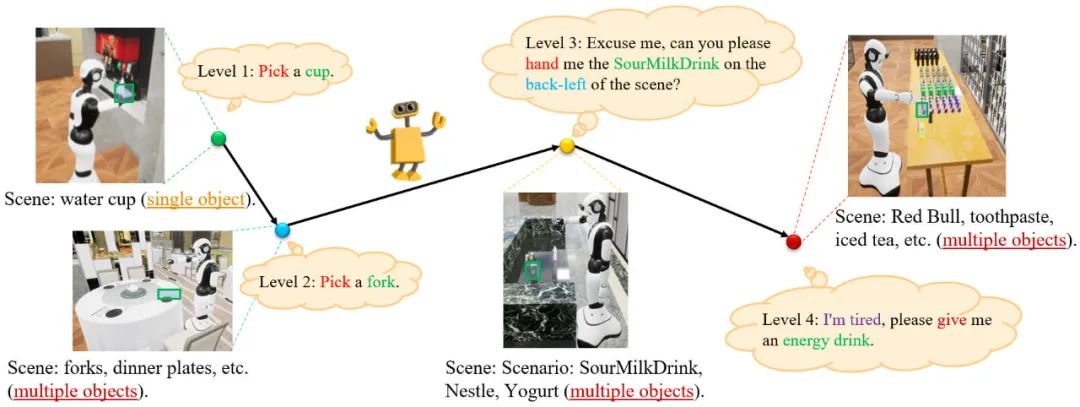

根据指令的复杂性和操作的难易程度将任务分为四个级别,如下图所示:

Level 1任务用于评估机器人的抓取能力。Level 2任务用于评估机器人在多目标环境中的识别和抓取能力。Level 3任务侧重于评估机器人理解简单的人类自然语言的能力。Level 4任务主要用于评估机器人理解复杂、模糊的人类自然语言指令和推理人类意图的能力。

构建了面向开放域零样本视觉语言导航的多任务基准测试,促进机器人视觉语言导航研究的快速发展

为了促进开放式视觉语言导航的研究,我们在HARIX RDK中构建了MO-VLN,一个面向开放域零样本视觉语言导航的多任务基准测试。MO-VLN专注于零样本视觉与语言导航,涉及根据语言指令导航到特定的目标对象、抽象对象和特定位置。具体来说,MO-VLN分为四个任务,如下图所示,即给定类别的对象导航、给定简单指令的目标导向导航、完全抽象指令和按步骤跟随指令。

在HARIX RDK的仿真场景中让智能体自主探索、结合其视觉自动构建拓扑语义地图,将开放词汇模型和大语言模型结合进行指令和场景理解,预测目标位置并逐步移动至目标位置,如下图所示:

这里,我们利用预训练的视觉-语言模型如GLIP/ Grounding DINO进行物体定位。在检测到可能的物体位置后,我们将它们投影到语义地图上。在环境探索上,我们只考虑zero-shot策略,如基于常识知识的探索。运用GLIP检测观察并获取关于周围环境的信息,能力较强的LLM可以根据其常识知识和检测结果更准确地预测下一个可能的位置。我们还让GPT-4在给定检测到的周围物体和区域的情况下完成常识推理。

项目网站:

https://necolizer.github.io/RM-PRT

https://mligg23.github.io/MO-VLN-Site

此次研究所用到的机器人产品是达闼自主研发的Cloud Ginger 1.0——柔美人形智能服务机器人,具有精准的视觉抓取能力、全方位的听、说、看、动等融合智能能力;开发平台使用的是达闼HARIX RDK机器人开发套件,可以实现机器人在智能语音、行为控制、动作编辑、移动导航等方面的能力开发,并完成数字孪生环境和真实机器人的虚实同步验证。

校企合作是促进创新和培养人才的有效机制,一直以来,达闼都很重视和高校的深度合作,近年来相继与复旦大学、同济大学、上海交大、上海大学、东北大学、安徽大学、西安理工大学、山东大学等多所高校,在人工智能课程设置、技术研发、人才培养等方面联合开展了多项合作,促进了学术研究与市场前沿的无缝结合,全方位发掘了云端机器人背后的价值及潜能。在达闼和中山大学的合作下,具身智能正以强劲的势头迈向新的里程碑。相信随着更多科学家和工程师的不懈努力,我们将迎来通用人工智能的崭新时代,智能体与人类在互动和合作中共同创造美好未来。