去年年底,ChatGPT橫空出世,在全球科技浪潮中掀起了驚濤駭浪,隨後,各個科技公司都開始着手打造自己的大模型,帶來各行各業效率的革命和體驗的升級。儘管大規模語言模型(LLMs,Large Language Models)可以進行複雜的語言生成和對話交流,但ChatGPT多模態感知、長期的運動規劃和行為交互能力有限,還不是人類理想的智能體。「具身智能」+「機器人」有望成為AI的下一個潮水涌動的方向。

近年來,達闥在具身智能領域持續加大研發投入,上周發佈了海睿AGI平台和機器人智能領域的多模態認知大模型——RobotGPT。達闥還與中山大學智能工程學院副教授、博士生導師梁小丹(國家萬人青拔人才)展開緊密合作,共同探索具身智能前沿科技:為機器人開發非常真實的模擬環境,創建兩個基準測試,助力機器人在自主推理和導航方面的研究更快地取得進展。

「具身智能」(Embodied Intelligence)意指有身體並支持物理交互的智能體,標杆產品是人形機器人。實現具身智能是指讓機器能夠像人一樣擁有身體感知、交互和行動的能力,這種能力使機器能夠更加自然地與物理世界進行交互。但是,實現具身智能面臨著以下困難和挑戰:

1 缺乏工業級真實感的機器人操作模擬器,缺少高質量具身智能訓練所需的海量數據

通過與模擬環境進行交互生成大量豐富的多樣的訓練數據,並進行端到端強化學習和模型學習是具身智能訓練的常用手段,當前業界的模擬器常常沒有將智能機器人製造技術考慮在內,也沒有足夠的關注真實機器人應用的兼容性。這導致研究者在這種環境中開發的控制技術常常難以在真實場景中得到應用。此外複雜多變的現實環境也給具身智能有效地理解和解析環境信息帶來了巨大的挑戰。

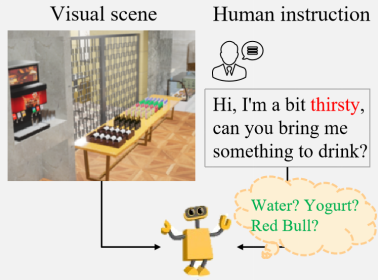

2 機器人(智能體)難以理解和執行複雜且不明確的人類自然語言指令,同時缺乏機器人操作相關的漸進式推理任務基準測試

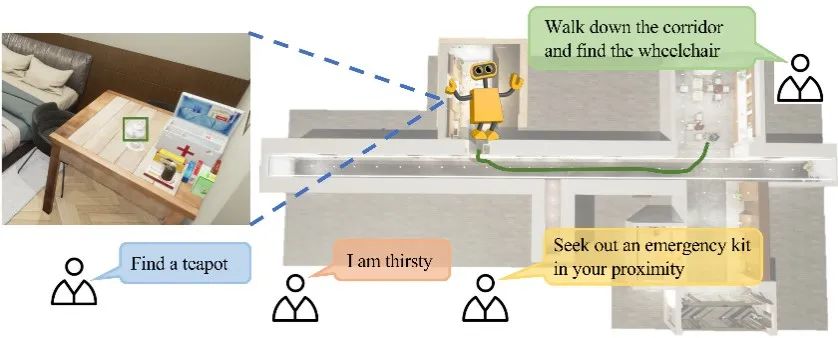

在具身智能研究中,人類的語言指令往往複雜多樣、模稜兩可、隨意性強,機器難以猜測和推理人類的真實意圖。比如我們對機器人說:「我有點渴,請給我拿點喝的」,如下圖所示,機器人需要充分理解人的意圖和場景中每個對象概念所隱含的功能,才能做出準確的判斷。因此,考慮如何讓機器人理解和執行複雜和模糊的人類自然語言指令是體現具身智能研究的關鍵挑戰之一。

3 缺乏面向開放域零樣本視覺語言導航的多任務基準測試

在具身智能領域,面對開放域零樣本視覺語言導航多任務基準測試的明顯缺失,主要是因為:仿真真實性不足,真實的開放環境下因素變化多端,比如突然走過來的行人;零樣本視覺語言導航模型需要處理其以前未曾遇到過的環境和任務,這要求基準測試的環境儘可能地接近現實;相較於封閉環境,開放環境中的元素更加複雜且不斷變化,現有的自動標註方法往往無法應對。

為了有效應對上述挑戰,我們需要追求更為真實的仿真環境,開發更為有效的數據收集和標註策略,制定更為全面的評估指標。因此,達闥積極與中山大學展開了深度合作,在以下三方面取得了階段性成果:

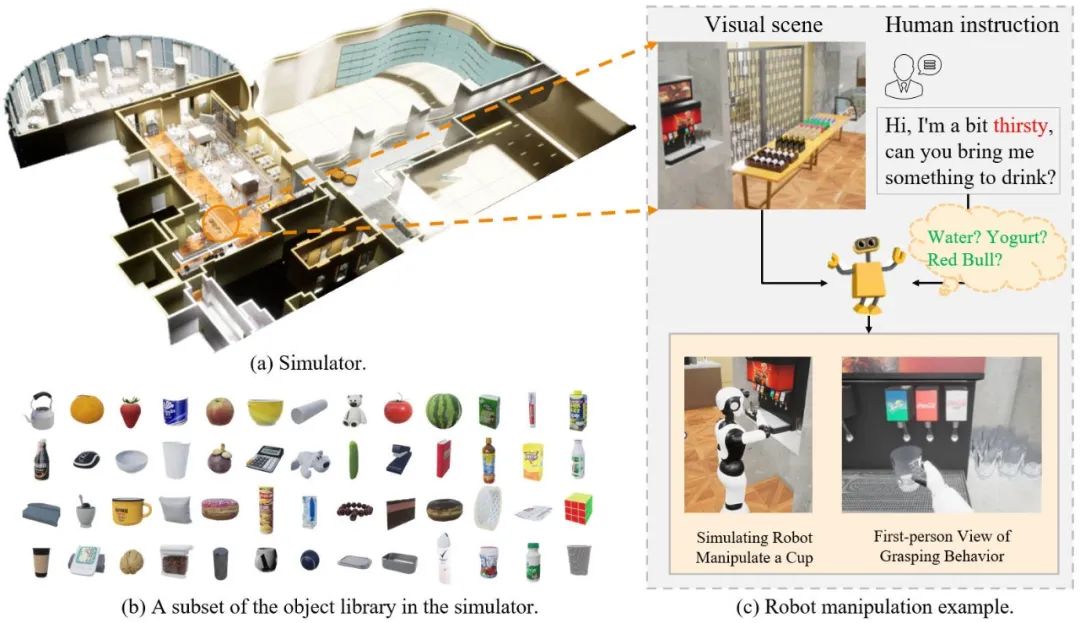

研發並開放工業級真實感的機器人具身智能訓練工具(HARIX RDK)

為了方便、公正地比較機器人在不同基線模型下理解和執行人類自然語言指令的成功率,我們構建了高度逼真的場景模擬與機器人具身智能訓練工具(HARIX RDK),用於機器人具身智能的研究,特點有:①有真實光照,能夠高擬真產生照明陰影、鏡面反射、亮斑等。②仿真環境中加入了人類,這些人類或處於通道中阻擋路徑或走入機器人行進路線。③環境可以通過讀取底層數據實現對各類物體進行細緻的語義分割標註,便於後續構建基準。④HARIX RDK可支持達闥公司研發的多種類型的機器人。

構建了機器人操作相關的漸進式推理任務基準測試,促進機器人漸進式推理研究的快速發展

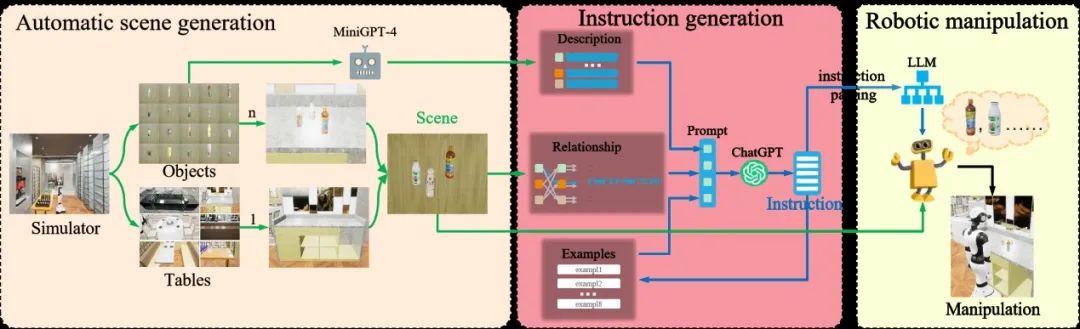

為方便分析和評估大語言模型在機器人操作中的應用,我們創建了一個通用的框架,如下圖所示,主要由三部分組成:自動場景生成、指令生成和機器人操縱。自動場景生成負責生成豐富多樣的場景供agent進行訓練和測試。由於獲取大規模複雜且高質量的人類自然語言指令既昂貴又困難,為此我們還設計了一個使用ChatGPT模擬人類自然語言指令生成的模塊,為機器人操作提供自然語言指令。最後,通過向機器人輸入生成的視覺場景和自然語言指令,控制機器人進行相應的操作。

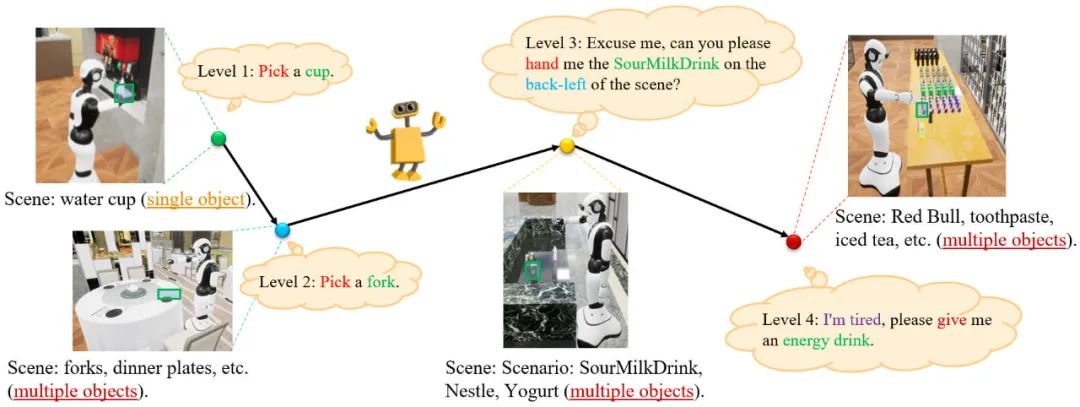

根據指令的複雜性和操作的難易程度將任務分為四個級別,如下圖所示:

Level 1任務用於評估機器人的抓取能力。Level 2任務用於評估機器人在多目標環境中的識別和抓取能力。Level 3任務側重於評估機器人理解簡單的人類自然語言的能力。Level 4任務主要用於評估機器人理解複雜、模糊的人類自然語言指令和推理人類意圖的能力。

構建了面向開放域零樣本視覺語言導航的多任務基準測試,促進機器人視覺語言導航研究的快速發展

為了促進開放式視覺語言導航的研究,我們在HARIX RDK中構建了MO-VLN,一個面向開放域零樣本視覺語言導航的多任務基準測試。MO-VLN專註于零樣本視覺與語言導航,涉及根據語言指令導航到特定的目標對象、抽象對象和特定位置。具體來說,MO-VLN分為四個任務,如下圖所示,即給定類別的對象導航、給定簡單指令的目標導嚮導航、完全抽象指令和按步驟跟隨指令。

在HARIX RDK的仿真場景中讓智能體自主探索、結合其視覺自動構建拓撲語義地圖,將開放詞彙模型和大語言模型結合進行指令和場景理解,預測目標位置並逐步移動至目標位置,如下圖所示:

這裏,我們利用預訓練的視覺-語言模型如GLIP/ Grounding DINO進行物體定位。在檢測到可能的物體位置后,我們將它們投影到語義地圖上。在環境探索上,我們只考慮zero-shot策略,如基於常識知識的探索。運用GLIP檢測觀察並獲取關於周圍環境的信息,能力較強的LLM可以根據其常識知識和檢測結果更準確地預測下一個可能的位置。我們還讓GPT-4在給定檢測到的周圍物體和區域的情況下完成常識推理。

項目網站:

https://necolizer.github.io/RM-PRT

https://mligg23.github.io/MO-VLN-Site

此次研究所用到的機器人產品是達闥自主研發的Cloud Ginger 1.0——柔美人形智能服務機器人,具有精準的視覺抓取能力、全方位的聽、說、看、動等融合智能能力;開發平台使用的是達闥HARIX RDK機器人開發套件,可以實現機器人在智能語音、行為控制、動作編輯、移動導航等方面的能力開發,並完成數字孿生環境和真實機器人的虛實同步驗證。

校企合作是促進創新和培養人才的有效機制,一直以來,達闥都很重視和高校的深度合作,近年來相繼與復旦大學、同濟大學、上海交大、上海大學、東北大學、安徽大學、西安理工大學、山東大學等多所高校,在人工智能課程設置、技術研發、人才培養等方面聯合開展了多項合作,促進了學術研究與市場前沿的無縫結合,全方位發掘了雲端機器人背後的價值及潛能。在達闥和中山大學的合作下,具身智能正以強勁的勢頭邁向新的里程碑。相信隨着更多科學家和工程師的不懈努力,我們將迎來通用人工智能的嶄新時代,智能體與人類在互動和合作中共同創造美好未來。